大语言模型技术发展与演进 软硬件协同创新的双轮驱动

大语言模型(Large Language Model, LLM)作为当前人工智能领域的皇冠明珠,其迅猛发展与演进,从根本上说是计算机软件与硬件技术深度协同、螺旋式驱动的结果。从最初的统计语言模型到如今的千亿、万亿参数规模,每一次质的飞跃都离不开底层计算架构、算法设计和工程实现的合力突破。

硬件基石:算力解放与架构革新

大语言模型发展的首要驱动力是计算硬件的持续演进。

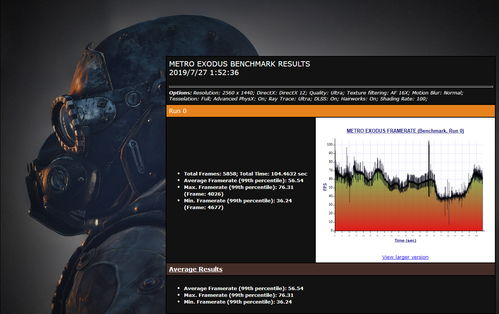

- GPU与并行计算的崛起:传统CPU的串行处理模式难以应对神经网络庞大的矩阵运算。以NVIDIA GPU为代表的并行计算架构,凭借其海量核心(CUDA Core/Tensor Core)和高带宽内存,成为训练LLM的绝对主力。其大规模并行处理能力,使得训练过去不可想象的超大规模模型成为可能。

- 专用AI芯片的涌现:为更极致地优化LLM训练与推理,谷歌的TPU、华为的昇腾、Graphcore的IPU等专用AI处理器应运而生。它们在芯片层面针对矩阵乘加、非线性激活等核心操作进行定制化设计,拥有更高的计算密度和能效比,进一步压低了训练成本与时间。

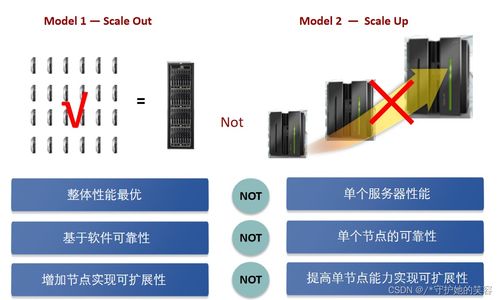

- 内存与互联技术的突破:LLM的参数规模动辄数百GB,远超单个处理器内存容量。高带宽内存(HBM)、NVLink/NVSwitch高速互联技术,以及分布式训练框架,使得成千上万个计算节点能够高效协同,如同一个巨型虚拟处理器,共同承载和运算整个模型。

软件灵魂:算法创新与系统优化

在硬件提供的算力舞台上,软件技术的创新则谱写了LLM能力的核心乐章。

- 模型架构的演进:从早期的RNN、LSTM处理序列数据的瓶颈,到Transformer架构的横空出世,其自注意力机制完美解决了长距离依赖问题,成为当今所有主流LLM的基石。GPT系列的自回归生成架构、T5的统一文本到文本框架、MoE(混合专家)模型等,都在此基础上不断优化模型效率与能力边界。

- 训练方法与算法的精进:

- 规模化定律(Scaling Laws):OpenAI等机构提出的缩放规律,为“大力出奇迹”提供了理论指导,明确了模型规模、数据量和计算量之间的量化关系。

- 高效的优化器与训练技巧:如AdamW优化器、学习率预热与衰减策略、梯度裁剪、混合精度训练等,极大地提升了训练稳定性和速度。

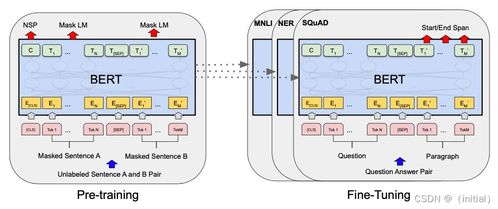

- 预训练-微调范式:在海量无标注文本上预训练获得通用语言理解与生成能力,再针对特定任务进行有监督微调(SFT),这一范式成为构建实用LLM应用的标准流程。

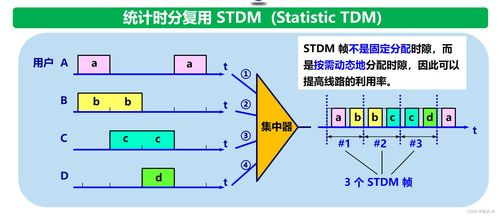

- 推理与服务系统的工程优化:模型训练完成后的部署是另一大挑战。模型压缩(如量化、剪枝、知识蒸馏)、动态批处理、持续批处理(Continuous Batching)、张量并行、流水线并行等推理优化技术,以及Triton Inference Server、vLLM等高性能推理引擎,使得百亿参数模型也能以较低的延迟服务海量用户请求。

软硬件协同:螺旋上升的演进路径

LLM技术的发展绝非软硬件的简单叠加,而是深度的协同设计与闭环反馈:

- 硬件定义软件可能:新一代GPU/TPU的Tensor Core直接针对Transformer的注意力机制进行优化,促使算法团队设计更充分利用该硬件的模型变体。

- 软件驱动硬件革新:LLM对显存带宽和容量的极致需求,反向推动HBM等内存技术的快速迭代;对低延迟推理的要求,催生了边缘AI芯片的发展。

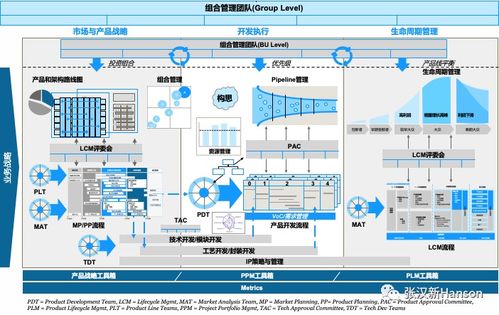

- 系统级协同优化:从PyTorch、TensorFlow等深度学习框架与CUDA的深度绑定,到Megatron-LM、DeepSpeed等分布式训练库对硬件集群拓扑的智能感知与调度,软硬件在系统层面已融为一体。

未来展望:面向更高效、更通用的智能

大语言模型的演进将继续在软硬件协同的轨道上深化:

- 硬件层面:下一代芯片将更注重训练与推理的能效比,存算一体、光计算等新型计算范式可能打破“内存墙”限制。面向Agent(智能体)持续交互的硬件支持将更受关注。

- 软件与算法层面:模型架构将继续追求“更聪明而非更庞大”,如更高效注意力机制、更优的稀疏化模型。训练过程将更注重数据质量、多模态融合以及对齐人类价值观(RLHF、DPO等)。推理端将追求极致的成本与延迟优化。

- 协同层面:从芯片到框架再到模型算法的全栈垂直优化将成为核心竞争力。软硬件协同设计(Co-design)将更加普遍,可能出现专门为某类革命性模型架构定制的超级计算系统。

大语言模型波澜壮阔的发展史,是一部计算机软硬件技术交织并进、相互成就的史诗。算力硬件的每一次跃迁都为模型规模的扩张打开新空间,而算法软件的每一次创新又对底层硬件提出新要求并挖掘其潜能。这场软硬共舞的双轮驱动,正以前所未有的速度,推动着通用人工智能(AGI)的轮廓日益清晰。

如若转载,请注明出处:http://www.dqryx.com/product/37.html

更新时间:2026-03-03 15:32:16